领雁科技助力深化银行经营数据分析,做好EAST5.0数据报送

EAST5.0数据报送在即,随着监管对各金融机构报送工作进行了制度更新,可以明显感觉出监管当局对金融机构监管方向从统计型指标监控到主题型业务数据报送,再到明细级业务数据报送的监管趋势,这是对金融机构在数据质量、数据治理层面提出了更高的要求。银行如何做好EAST5.0的数据报送?北京领雁科技在详细分析了EAST5.0的变化及要求基础上,总结了解决方案。

在今年1月30日,银保监会正式下发《中国银保监会办公厅关于印发银行业金融机构监管数据标准化规范(2021版)的通知》(即EAST5.0)。报送接口涉及到11个监管主题域、70张数据表、1838个数据项,其中新增15张表、删除5张整表、合并11张表变成5张表。针对EAST4.0升级至EAST5.0,金融机构面临着许多难点。首先,距离报送的时间要求短、除了后续正常报送外,还需要6个时点和最近2年的交易流水数据补报送;其次,EAST5.0报送的业务范围全面、涉及到金融机构的业务部门和源系统多,如果还没有建设数仓或者监管数据集市的话,对接的业务数据分散;最后,EAST5.0要求报送的数据质量高,包括检核规则强校验、与1104、客户风险等其他报送系统的联动交叉校验。

在EAST4.0数据报送中,许多金融机构存在错报、漏报、偏差、未报、不一致等数据质量问题,均遭到了不同程度的行政处罚。处罚金额合计高达8760.00万元(最低处罚:290.00万,最高490.00万,平均:417.14万)。例如:对公信贷业务借据、表外授信业务等存在错报;贷款核销业务、抵押物价值、信贷资产转让业务、贸易融资业务等存在漏报;理财产品底层持仓余额、理财产品非标投向行业余额、逾期90天以上贷款余额、不良贷款余额等业务数据存在偏差;权益类投资、其他担保类、委托贷款、公募基金投资、跟单信用证、私募基金投资等业务存在未报;理财产品销售端与产品端数据、分户账与总账等业务交叉校验存在不一致。

在即将到来的EAST5.0数据报送中,除了以上EAST4.0已经存在的问题外,金融机构还需要格外关心:总分检核、连续性、存在性、一致性、检核规则中的强校验等违规点。

如何提升金融机构监管报送质量,确保不多报、不漏报、不错报等风险。通常方法有:技术检核规则校验、业务检核规则校验、系统之间交叉校验。北京领雁科技的统一监管报送平台提供丰富的校验规则库,包括监管数据集市层校验规则库(存在性校验、完整性校验、唯一性校验、空值校验、域值校验、表间校验、总分校验等),指标层支持预警校验、阈值校验;明细报送层有自身的报送层校验规则库(例如:EAST报送层校验、金融基础数据报送层校验、存款保险报送层校验等);明细报送与指标交叉联动校验等。从系统层充分的保障集市层、汇总层、指标层、报送层各层的业务数据的准确性和完整信息。确保不多报、不漏报、不错报等风险,提升监管报送业务人员工作效率和监管报送的合规性。

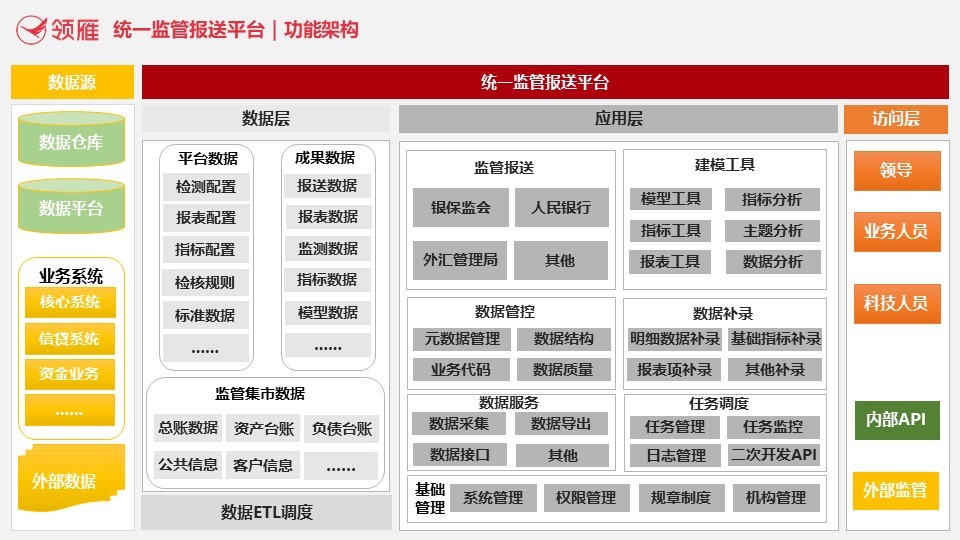

北京领雁科技自成立以来,专注于金融科技领域,经过多年的业务积累,其统一监管报送系统具有:监管数据集市模型、监管指标体系管理、灵活的模块化配置、完整交叉校验体系等多个特点。例如,监管数据集市模型从明细层到汇总层、指标层、报送层,将数据按照业务类型合理的分类及汇总,从而达到数据表内或表间业务逻辑的一致性,有效降低了跨系统、跨模块、跨表、跨指标之间的错误率,统一了数据报送来源,帮助了金融机构做到快速溯源查询,提高了数据的正确性、真实性和报送效率,为后续的系统建设提供良好的数据支持。

北京领雁科技统一监管报送系统就可以满足在统一数据及应用平台之上支持业务数据的统一查询、补录、核对、审批以及处理复杂数据和应用逻辑,并搭建各类报送的应用子系统,实现全行级的“统一数据平台、统一补录平台、统一调度平台、统一指标平台、统一报表平台、平台协同处理、统一报送平台和统一管理平台”的建设目标。不仅满足面向人民银行、银保监会、外汇管理局三大监管机构的报送平台整合,还可以实现各报送平台的无限扩展和资源的有效利用。不仅可以达成合规,更可以进一步支撑深化银行自身的经营数据分析,助力银行客户深度经营。

北京领雁科技的统一监管报送平台不仅为监管报送而报送,更是为进一步深化银行自身的经营数据分析、决策提供数据支撑。从而实现业务数字化、精细化管理;提升业务管理效能、风险管理效能和客户风险识别广度精度。在金融创新的科技驱动和数据赋能下,从而进入真正的金融数字化转型。

好文章,需要你的鼓励

奥运级别的努力:首席信息官为2026年AI颠覆做准备

AI颠覆预计将在2026年持续,推动企业适应不断演进的技术并扩大规模。国际奥委会、Moderna和Sportradar的领导者在纽约路透社峰会上分享了他们的AI策略。讨论焦点包括自建AI与购买第三方资源的选择,AI在内部流程优化和外部产品开发中的应用,以及小型模型在日常应用中的潜力。专家建议,企业应将AI建设融入企业文化,以创新而非成本节约为驱动力。

字节跳动发布GAR:让AI能像人类一样精准理解图像任何区域的突破性技术

字节跳动等机构联合发布GAR技术,让AI能同时理解图像的全局和局部信息,实现对多个区域间复杂关系的准确分析。该技术通过RoI对齐特征重放方法,在保持全局视野的同时提取精确细节,在多项测试中表现出色,甚至在某些指标上超越了体积更大的模型,为AI视觉理解能力带来重要突破。

Spotify推出AI播放列表功能让用户掌控推荐算法

Spotify在新西兰测试推出AI提示播放列表功能,用户可通过文字描述需求让AI根据指令和听歌历史生成个性化播放列表。该功能允许用户设置定期刷新,相当于创建可控制算法的每周发现播放列表。这是Spotify赋予用户更多控制权努力的一部分,此前其AI DJ功能也增加了语音提示选项,反映了各平台让用户更好控制算法推荐的趋势。

Inclusion AI推出万亿参数思维模型Ring-1T:首个开源的超大规模推理引擎如何重塑AI思考边界

Inclusion AI团队推出首个开源万亿参数思维模型Ring-1T,通过IcePop、C3PO++和ASystem三项核心技术突破,解决了超大规模强化学习训练的稳定性和效率难题。该模型在AIME-2025获得93.4分,IMO-2025达到银牌水平,CodeForces获得2088分,展现出卓越的数学推理和编程能力,为AI推理能力发展树立了新的里程碑。

为AI+而生,海辰储能发布全球首款锂钠协同AIDC全时长储能解决方案

长时储能开启智慧未来:海辰储能生态日全球首发三大新品

Arm 借助融合型 AI 数据中心,重塑计算格局

奥运级别的努力:首席信息官为2026年AI颠覆做准备

Spotify推出AI播放列表功能让用户掌控推荐算法

Adobe押注生成式AI获得回报,年度营收创历史新高

OpenAI与迪士尼达成十亿美元合作协议,米老鼠和漫威角色进入Sora

甲骨文150亿美元数据中心投资导致股价下跌

Spoor鸟类监测AI软件需求飞速增长

制药行业AI数据质量危机:垃圾进垃圾出的隐患

Harness获得2.4亿美元融资,估值达55亿美元,专注自动化AI编码后的开发流程

英伟达CEO黄仁勋独家专访:万亿美元押注AI工厂将成为新时代计算机

Google 在 Colab Python 平台推出免费的 Gemini 驱动数据科学助手

Taktile 助力金融科技公司构建自动化决策工作流

金融科技现处"艰难时期",但最新报告显示复苏迹象

SAP Business Suite 重启计划引发用户关注

Anthropic 经济指数 — 企业领导者必知的 10 大 AI 工作场所趋势

Corporate One 通过数据编排中心实现即时支付

2025年你需要了解的5个ChatGPT省时省钱技巧

TigerGraph 升级图数据库产品,实现更快部署速度和全新预配置方案

小猪存钱罐的消亡标志着金融科技的成年

AI 数据公司主导 BestBrokers 最新独角兽企业榜单