端云一体化云开发,助推HarmonyOS应用与元服务高效开发

在不久前召开的华为开发者大会2023(HDC.Together)上,来自全球的开发者汇聚一堂,共同探索鸿蒙生态的最新进展,体验HarmonyOS最新技术。通过主题演讲、丰富的现场活动以及案例分享等,“云开发”的降本增效、创新体验被频繁提及,受到更多开发者的关注和认同。

在大会的技术论坛环节,母婴行业知名品牌“孩子王”的CTO用实践案例分享了“‘孩子王’元服务使用端云一体化·云开发的创新体验”。云开发为“孩子王”元服务提供了助力,其云端Serverless免运维、弹性伸缩等特性,使得“孩子王”元服务的开发效率提升60%,资源成本节省40%。

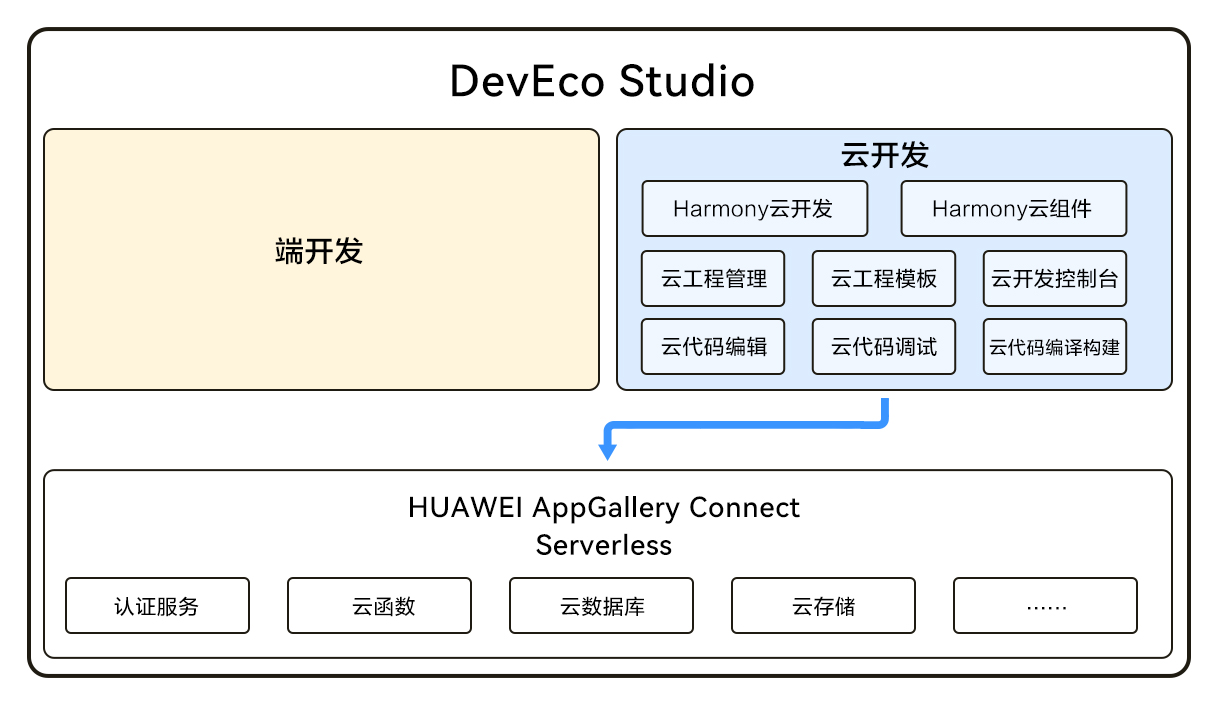

云开发是(高码)端云一体化开发,主要针对广大开发者在产品开发过程中可能遇到的端云割裂、开发效率低、沟通成本高等问题给出解决方案。开发者只需在HUAWEI DevEco Studio内选择云开发模板,一个开发团队、一套开发工具、一种开发语言,即可完成HarmonyOS应用/元服务端侧与云侧的开发。

端云协同开发,助力开发者低成本学习快速上手

通常来讲,同时完成端云两侧的开发要求开发者具备较高的专业技能,这对于不少初创团队及个人开发者而言是存在一定难度的。云开发则降低了对开发者的技能要求,学习成本低,一种开发语言即可同时支撑端云两侧的开发,帮助有基础知识储备的开发者快速上手。

元服务“随手计数”是一款个人开发者的作品。开发者之前对云开发并不了解,但其在通过文档自学和对云开发工具的探索后,顺利完成了第一款元服务作品的开发和上架。开发者表示,虽然是第一次使用云开发模板,但前期准备过程非常简单,仅需在HUAWEI AppGallery Connect(以下简称“AGC”)管理端花点时间新建项目,后续开发时无需任何配置便能直接使用,学习成本低,上手快。

端云统一技术栈,促进开发效率显著提升

传统开发模式端云割裂,需要较高的人力投入和持续的沟通成本,对很多开发者而言,在有限的资源内高效完成产品需求是有难度的。云开发端云统一技术栈,无需切换端侧与云侧工程、无需学习多种前后端语言,端侧人员也可编写云侧代码。

元服务“溜溜骰子”的开发即验证了这一点。 “溜溜骰子”的云侧逻辑主要用云函数和云数据库去实现,在使用过程中,用户每次摇骰子,都会带来流量的上升,流量与摇骰子次数成正比。多个玩伴共同使用,还会产生裙带效应,使流量翻倍攀升。

传统模式下,一个人想完成端、云侧的开发很难,云开发降低了开发门槛,且保障“溜溜骰子”的开发效率提升2倍以上。

Serverless优势凸显,有效降低资源成本

云开发的云端接入AGC Serverless服务,Serverless服务让开发者只需专注于业务逻辑,无需关心服务器、操作系统以及容器等基础设施,有效提升资源利用率,降低资源成本。

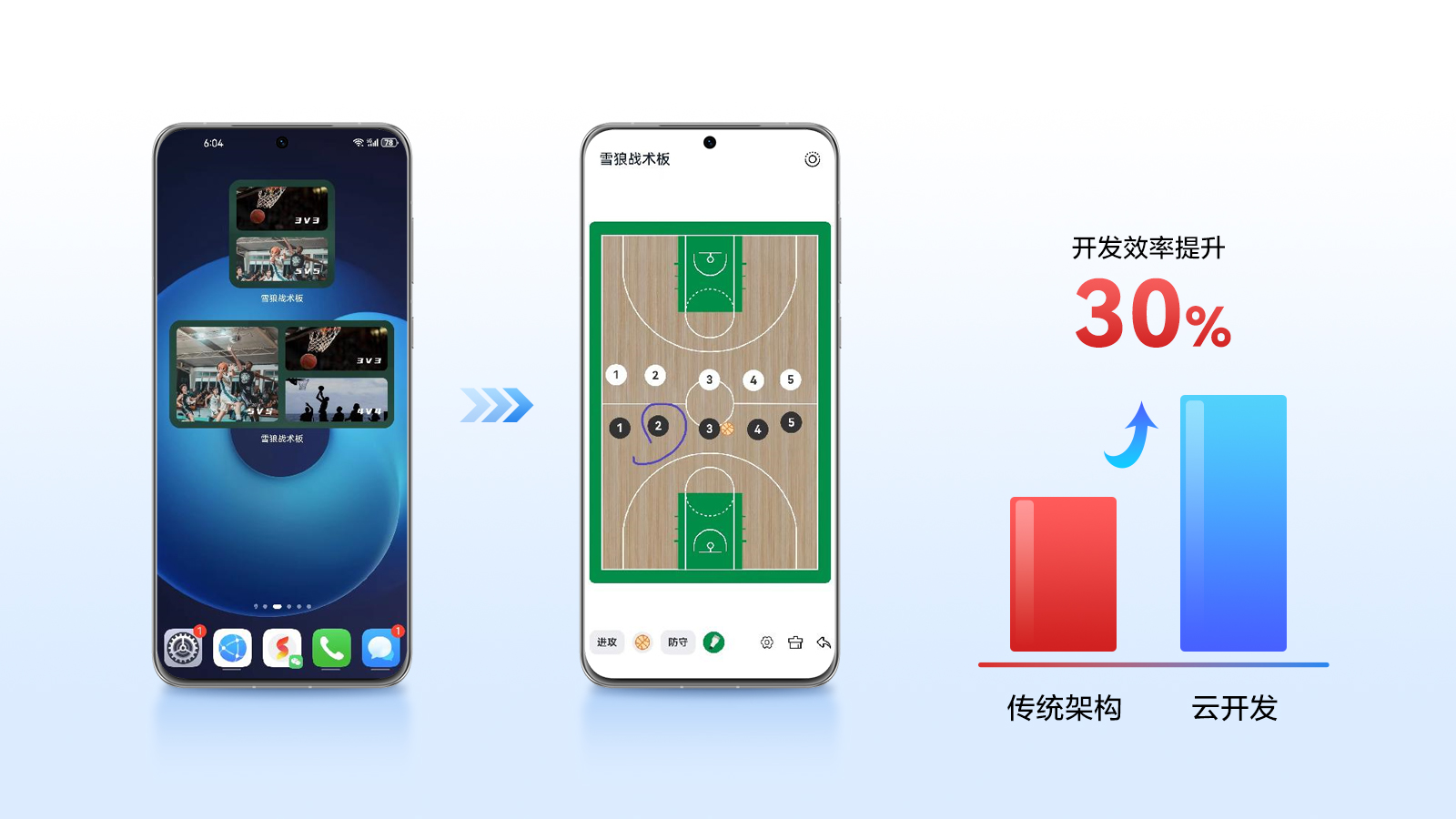

作为一款基于青少年篮球活动场景设计的工具,元服务“雪狼战术板”涉及大量数据内容,传统模式进行产品设计不便于切换终端设备后的数据获取,借助云开发完成产品的迭代后,依托Serverless服务,其可将画笔轨迹、进攻/防守人物相关数据全部保存在云数据库中。值得注意的是,开发者仅花费3小时就完成了项目上云的迁移,效率提升30%。

除了“雪狼战术板”,元服务“无聊数学”接入Serverless认证服务、云函数、云数据库、云存储服务以及Serverless模板能力后,降本增效亦十分明显。粗略计算,接入Serverless服务节约了开发成本15人天,开发效能提升27.3%。同时,由于项目全部采用华为的云架构,硬件资源成本方面,亦减少了3台约8核16GB的服务器投入。

如果您对HarmonyOS应用/元服务开发有着浓厚的兴趣,在开发过程中遇到了同样的难题和痛点,不妨尝试一下“云开发”。登录华为开发者联盟学堂官网学习HarmonyOS云开发课程,体验端云一体化·云开发,实现低成本高效开发,共建共赢更加美好的鸿蒙世界。

来源:业界供稿

好文章,需要你的鼓励

据说算力高达1000 TOPS,华硕Ascent GX10深度评测——开箱

当超级计算机被压缩进一个比书本还小的盒子里,这画面有多炸裂?想象一下,你桌面上摆着的不是什么花瓶摆件,而是一台能跑200B参数AI推理的"超算怪兽"——这就是我们今天要聊的主角:华硕Ascent GX10。

Adobe与UCLA联手突破AI模型速度瓶颈:让图像生成快一倍的“稀疏化魔法“

Adobe研究院与UCLA合作开发的Sparse-LaViDa技术通过创新的"稀疏表示"方法,成功将AI图像生成速度提升一倍。该技术巧妙地让AI只处理必要的图像区域,使用特殊"寄存器令牌"管理其余部分,在文本到图像生成、图像编辑和数学推理等任务中实现显著加速,同时完全保持了输出质量。

不用再训练AI模型,香港科技大学团队发明“智能管家“,让AI一眼就知道该抓哪里用哪里

香港科技大学团队开发出A4-Agent智能系统,无需训练即可让AI理解物品的可操作性。该系统通过"想象-思考-定位"三步法模仿人类认知过程,在多个测试中超越了需要专门训练的传统方法。这项技术为智能机器人发展提供了新思路,使其能够像人类一样举一反三地处理未见过的新物品和任务。

据说算力高达1000 TOPS,华硕Ascent GX10深度评测——开箱

苹果发现:只需一个注意力层,就能让AI图像生成既快又好

YouTube推出基于Gemini 3的创作者游戏制作工具

英伟达是唯一能负担免费提供AI模型的厂商

OpenAI发布新旗舰图像生成AI模型GPT Image 1.5

脑启发算法可大幅降低AI能耗

Mac办公桌升级必备配件指南:提升工作效率的最佳选择

PTC Windchill+ 助力 HOLON研发全球首批符合汽车行业标准的 L4 级电动汽车

航旅行业的AI“乘法效应”:迈向指数级进化

OpenAI推出GPT Image 1.5模型加速图像生成竞争

Zoom推出AI Companion 3.0智能体工作流程

ChatGPT成为互联网最受阻止的爬虫机器人

干货和福利都为你准备好了!HarmonyOS公开课报名持续至8月10日

华为游戏中心携网易等伙伴参展CJ,鸿蒙原生游戏成最大看点之一

与天才少年同框!HarmonyOS公开课将招募百名青年学子走进华为

华为阅读携手人民邮电出版社上架独家鸿蒙相关书籍,覆盖鸿蒙开发全流程

机会来了!HarmonyOS NEXT开发者Beta第二期来袭!

HarmonyOS NEXT助力未来:南昌航空大学周子萌的开发者之旅

HarmonyOS NEXT 赋能小红书,引领社交媒体平台全新沉浸式体验

高德地图携手HarmonyOS NEXT,打造智能出行极致用户体验

HarmonyOS NEXT赋能南方航空,打造民航出行的极简高效体验

建立新秩序 HarmonyOS NEXT星盾安全架构打造真正原生安全