最新 GigaOm 雷达报告发布,Vertica 称雄全球数据仓库市场

2023 年 1 月 17 日,OpenText 旗下核心分析数据库、湖仓一体的统一分析平台 Vertica 宣布,其连续三年被 GigaOm 雷达报告评为“全球数据仓库领导者”。

新年,数据库行业需要新的专业之声

一体化数据湖仓的出现点燃了传统数据库行业的激情,正在阅读本文的你,就很有可能正计划着一次大的现代化改造,甚至是——“重新平台化”,以自身变革主动满足千变万化的分析用例。

但选择最合适的数据仓库——或者更准确地说——选择最合适的数据分析平台是一个挑战。这是一个数十亿美元的投资市场,过度的炒作舆论等甚嚣尘上。我们需要专业的声音。

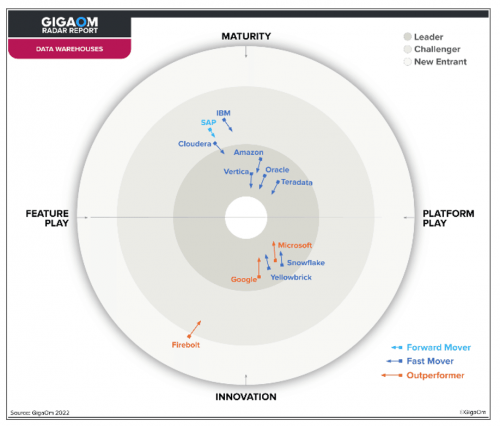

现在有一份全新的数据库行业报告摆在你面前,完整清晰呈现当前的数据仓库景观——《GigaOm 数据仓库雷达报告》。用 GigaOm 自己的话说,它是为了提供“IT 决策者所需信息,以选择最适合他们的业务和用例要求”而生的。

Vertica,当之无愧的数据仓库领导者

图源:GigaOm 数据仓库雷达报告

其中 Vertica 表现不凡。它作为 Micro Focus 软件组合的核心分析数据库,在包括市场分类的大型企业类别、以及用户分类的数据分析师和数据工程师等类别中均获得卓越评级。

在关键性标准方面,Vertica 在多集群架构、高级数据治理和安全、数据摄取和数据复制等方面获得了突出评级。最重要的是,Vertica 在整六项评估指标中共获五项卓越评级,最终处于 GigaOm 雷达图(见上方)最接近中心的位置,成为名副其实的全球数据仓库领导者及快速前进者。

GigaOm 报告称:“Vertica 提供了广泛的数据库内高级分析、机器学习功能以及灵活的部署模式;此外,所有的功能都基于同一许可证提供,没有基础设施或云存储的专有标记,也无需额外许可证以访问其它分析工具。”

报告对 Vertica 的核心见解还包括:

Vertica 分析数据库拥有独立于基础设施、可扩展且高灵活的数据仓库和分析能力,在多类别中均获得卓越评级,同时其对前瞻性产品及功能的创新投入也赢得了广泛赞誉

Vertica 在市场分类的大型企业类别、以及用户分类的数据分析师和数据工程师等类别中获得卓越评级——这是最高评级

Vertica 被 GigaOm 评价为“着眼于未来”,近期发布的 Vertica Accelerator 是其数据库即服务(DBaaS)产品,它即将推出更多增强能力以飨客户

对此,Vertica 相关负责人表达了其态度:“我们很高兴连续三年被 GigaOm 评为 数据仓库市场领导者,该认可证实了 Vertica 团队所有成员的集体承诺,我们的员工每天都在努力为世界提供一流的数据库和数据分析解决方案。”Micro Focus Vertica 产品部门营销副总裁 Jeff Healey 说。“数据仓库必须主动适应不断变化的业务需求、融合不断涌现的技术创新和不断发展的真实用例。而 Vertica 所做的一切,就是通过不断增长的数据库内功能满足客户从现在到未来的所有需求,并确保他们可以在任何地方、以任何规模享受高性能数据分析带来的好处。”

关于 Vertica

湖仓一体的统一分析平台 Vertica,是 OpenText 旗下核心的大数据分析平台。它具有大规模可扩展的架构,具有广泛的分析功能集,涵盖事件和时间序列、模式匹配、地理空间和端到端的数据库内机器学习等。并能将其轻松应用于苛刻的大数据分析挑战。

从飞利浦到中国电信,从萃奕到美国万通,Vertica 服务于众多全球领先的数据驱动型企业,提供市场上无与伦比的速度,以及指导业务策略的预测性洞察力。最新 Vertica 12 版本提供基于 AWS 的 SaaS 服务,并通过 BYOL(自带许可证)模式跨企业内部数据中心、主要公共云、多云及容器化环境等,帮助您快速处理海量数据。

来源:业界供稿

好文章,需要你的鼓励

SanDisk重塑经典SSD品牌:WD Black和Blue正式更名为Optimus系列

西部数据闪存业务分拆后,SanDisk宣布将停用广受欢迎的WD Black和Blue品牌,推出全新的SanDisk Optimus系列NVMe产品线。WD Blue驱动器将更名为SanDisk Optimus,而高端WD Black驱动器将分别更名为Optimus GX和GX Pro。尽管品牌变更,底层硬件和供应链保持不变。然而受全球内存短缺影响,预计2026年第一季度客户端SSD价格可能上涨超过40%。

上海AI实验室研究者想出妙招:让AI像优秀学生一样高效思考,告别“想太多“毛病

上海AI实验室开发RePro训练方法,通过将AI推理过程类比为优化问题,教会AI避免过度思考。该方法通过评估推理步骤的进步幅度和稳定性,显著提升了模型在数学、科学和编程任务上的表现,准确率提升5-6个百分点,同时大幅减少无效推理,为高效AI系统发展提供新思路。

福特汽车准备在车载系统中引入AI智能助手

福特汽车在2026年消费电子展上宣布将在车辆中引入AI助手技术。该AI助手最初将在福特和林肯智能手机应用中推出,从2027年开始成为新车型的原生功能。福特希望通过AI技术实现车辆个性化体验,提供基于位置、行为和车辆能力的智能服务。同时,福特将采用软件定义车辆架构,推出自研的高性能计算中心,提升信息娱乐、驾驶辅助等功能。

MIT团队让机器人终于不再“卡顿“:一种让机器人像人一样流畅反应的突破性技术

MIT团队开发的VLASH技术首次解决了机器人动作断续、反应迟缓的根本问题。通过"未来状态感知"让机器人边执行边思考,实现了最高2.03倍的速度提升和17.4倍的反应延迟改善,成功展示了机器人打乒乓球等高难度任务,为机器人在动态环境中的应用开辟了新可能性。

智能体驱动全球创新浪潮,微软携手前沿伙伴迈进消费电子新未来

达索系统在CES 2026上展示AI驱动的医疗创新, 重塑精准、可预测与个性化医疗

Arm 发布 20 项技术预测:洞见 2026 年及未来发

美光推出全球首款面向客户端计算的 PCIe 5.0 QLC SSD

SanDisk重塑经典SSD品牌:WD Black和Blue正式更名为Optimus系列

福特汽车准备在车载系统中引入AI智能助手

ChatGPT推出健康模式:结合医疗数据提供个性化建议

福特推出AI数字助理及新一代BlueCruise自动驾驶技术

联想Legion Pro可卷曲概念机展现移动大屏游戏新体验

印度和新加坡在智能体AI采用方面超越全球同行

华硕CES 2026新品:更小巧的ProArt GoPro笔记本和升级版Zenbook Duo

n8n警告CVSS满分漏洞影响自托管和云版本