HarmonyOS 联合绿盟发布折叠屏软件规范,携HUAWEI Mate X3带来创新折叠体验

3月23日,华为举行春季旗舰新品发布会,发布了一系列搭载HarmonyOS的终端新品。其中,全新一代折叠旗舰HUAWEI Mate X3备受关注,其凭借轻薄四曲折叠设计、快速发展的折叠应用生态、HarmonyOS 3.1 全新升级的智慧多窗以及悬停状态下的创意功能玩法,软硬一体为折叠屏手机带来更加优秀的阅读、观影、办公及游戏体验。

此外,早在2019年,华为便与软件绿色联盟首发了《折叠屏移动智能终端白皮书》,有效助推了折叠屏行业朝着规范化的方向发展。本次发布会上,华为再次携手软件绿色联盟发布了折叠屏软件设计与开发行业规范,以帮助应用开发者轻松实现折叠屏适配,持续引领折叠屏应用生态发展,为整个产业实现更加个性易用的人机交互体验做出重要贡献。

打造创新折叠大屏体验,引领应用生态发展

众所周知,受益于产品形态的优势,折叠屏在展开状态下拥有更大的屏幕尺寸,理应能够带来更为沉浸式的视觉体验。但是,更大的屏幕尺寸让应用适配成为一大问题,也从根本上影响着用户在折叠屏手机上的使用体验。

为给用户提供更沉浸的大屏体验,HUAWEI Mate X3此次带来了全新的双屏桌面功能,在屏幕展开时可以显示两屏桌面,用户可以在大屏上浏览更多应用图标和万能卡片,效率更高。

HUAWEI Mate X3基于人因研究,对主流的头部应用布局和操作进行了重新设计,带来了更多令人愉悦的体验。比如,在HUAWEI Mate X3打开搜狐新闻,支持双列刷新闻,排版布局更美观,阅读体验更高效;打开新浪微博,正文与评论区分屏显示,实现边看边评,大幅提升了用户在大屏状态下的用机体验。

分屏体验更智能,引领折叠屏效率革新

HarmonyOS 3.1加持,HUAWEI Mate X3智慧多窗功能再进化,让工作更高效,生活更精彩。全新智慧多窗支持一步智能分屏操作,单指向左上方滑动,进入待分屏状态,然后点击桌面另一应用便能一步开启分屏。比如校对视频的同时摘抄笔记,或者一边购物,一边聊天。

此外,在全屏播放视频和玩游戏时选择分屏,系统能够智能识别该场景更适合上下分屏模式,让同样的分屏操作,实现更佳的体验效果。比如,工作中开视频会议,一步智能分屏,上半屏听会,下半屏做笔记,视野更宽阔,操作更高效。娱乐休闲时,使用一步智能分屏,上半屏观看视频,下半屏游戏、聊天,操作两不误。

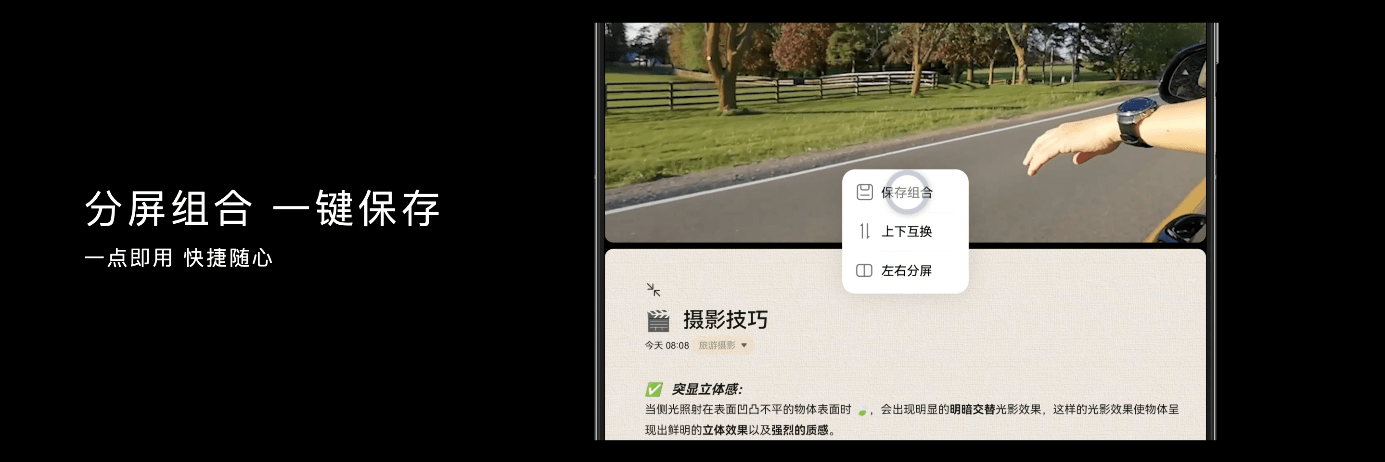

不仅如此,用户也可以点击“三个点按钮”,快速在上下分屏和左右分屏之间切换。同时,分屏组合还支持一键保存组合至桌面,便于下次使用时快速打开。

悬停交互自由灵活,解锁更多创意玩法

基于HUAWEI Mate X3半折叠的悬停状态,HarmonyOS 3.1设计了更自由灵动的交互方式,可以解锁影音娱乐、工作生活等场景新玩法。

影音娱乐方面,悬停状态下可以实现上屏观影,在下屏控制包括调节亮度、音量、进度以及播放暂停等操作,与全屏状态操作逻辑一致,用户一上手就会操作。日常使用时,将HUAWEI Mate X3放置于桌面,用户可以进行悬停视频通话,此时不仅主画面与操控分区显示,还可以进一步解放双手,实现灵活互动。同时HUAWEI Mate X3还带来了全新的悬停熄屏显示,实时显示天气,在休憩时刻伴你左右。

HUAWEI Mate X3借助HarmonyOS 3.1进一步解放折叠屏在不同形态下的优势,未来,华为将继续与行业合作伙伴一起,引领折叠屏手机应用生态发展,为消费者带来更加丰富的创新体验。

来源:业界供稿

好文章,需要你的鼓励

Queen‘s大学重磅研究:程序员的角色即将彻底改变,从码农到智能体指挥官

Queen's大学研究团队提出结构化智能体软件工程框架SASE,重新定义人机协作模式。该框架将程序员角色从代码编写者转变为AI团队指挥者,建立双向咨询机制和标准化文档系统,解决AI编程中的质量控制难题,为软件工程向智能化协作时代转型提供系统性解决方案。

苹果发布 iOS 26.0.1 系统更新,修复多项关键问题

苹果在iOS 26公开发布两周后推出首个修复更新iOS 26.0.1,建议所有用户安装。由于重大版本发布通常伴随漏洞,许多用户此前选择安装iOS 18.7。尽管iOS 26经过数月测试,但更大用户基数能发现更多问题。新版本与iPhone 17等新机型同期发布,测试范围此前受限。预计苹果将继续发布后续修复版本。

医疗AI的“显微镜革命“:西北工业大学团队发布首个超声影像专用智能助手EchoVLM

西北工业大学与中山大学合作开发了首个超声专用AI视觉语言模型EchoVLM,通过收集15家医院20万病例和147万超声图像,采用专家混合架构,实现了比通用AI模型准确率提升10分以上的突破。该系统能自动生成超声报告、进行诊断分析和回答专业问题,为医生提供智能辅助,推动医疗AI向专业化发展。

业界首款符合AEC-Q200标准额定电压高达1,000 VDC高压保险丝

数据中心的智算挑战,英特尔要如何应对?

下一代智能工厂怎么建?开放自动化给出“解题思路”

跟随西门子,在工博会感受沉浸式的工业AI体验

苹果发布 iOS 26.0.1 系统更新,修复多项关键问题

OpenAI将发布类似TikTok的社交应用,搭配Sora 2视频模型

微软推出Office智能体模式让用户"氛围办公"

AI助手现在能帮你创建高质量Word文档和Excel表格

高通新一代骁龙平台将推动智能体AI时代到来

SAPx阿里云,开启一条通往中国市场与全球化发展的全新路径

微软推出"氛围工作"模式,为Office套件加入AI智能体

OpenAI推出智能购物系统挑战谷歌亚马逊