微众银行隐私计算助力医疗数据流通,合作构筑科创平台协作新生态

过去的健康大数据大多是信息孤岛,如何实现数据合法合规地共享应用?

近日,国家健康医疗大数据研究院、微众银行、华链医疗科技有限公司三方协作,共同为国家健康医疗大数据科技创新应用平台(下称“科创平台”)引入微众银行场景式隐私保护解决方案WeDPR,应用WeDPR隐私计算技术实现在保护数据隐私安全的前提下,开展医疗数据分析研究。

国家健康医疗大数据研究院是科创平台的技术支撑方,也是国家健康医疗大数据中心(北方)的重要组成部分,集“政、产、学、研、用”为一体,专注健康医疗大数据研究与转化。华链医疗科技有限公司是科创平台协作端的软件服务方之一,致力于构建领先的医学科学数据协作网,专注医学研究和数据应用解决方案。

引入隐私计算技术,科创平台构筑协作新生态

在医疗领域,疾病数据合法合规共享是亟待解决的难题。一方面,当一家医院对患者实施治疗后,若患者转到其他医院就医,该医院就无法判断诊疗手段是否有效。另一方面,医疗数据属于个人敏感数据,一旦被泄露或被恶意使用,将产生严重的人格尊严、人身、财产安全风险。所以,如何在共享使用的同时做好隐私保护问题是重中之重。隐私计算作为一种可行的技术手段,可在保护数据隐私安全的前提下,实现医疗数据分析研究。

基于WeDPR,科创平台集成联合统计、联合建模、联合预测、匿踪查询、隐私求交等隐私计算能力,构建了一套与外部医院、保险公司、体检中心等医疗机构进行多中心科研的隐私协作机制。各方的原文数据均无需出库,通过WeDPR进行多方大数据隐私计算,实现应对多场景规模化的医疗数据再利用。

以多中心科研中的疾病分析场景为例,科创平台设计了集隐私查询、隐私统计、隐私建模、隐私预测功能于一体的解决方案,助力医院对患者信息的跟踪维护、对诊疗方案的升级、对诊疗效果的预判。

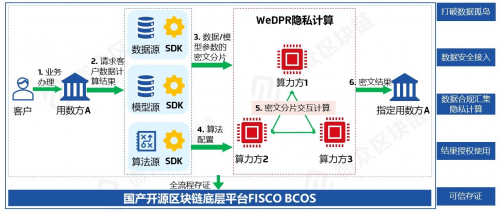

图 健康医疗大数据全栈式智能工程系统

未来,科创平台将进一步提升医疗机构重点疾病的研究水平和防治能力,推动多中心大数据临床试验BRCT、现实世界研究BRWS、精准医学研究和智慧医疗的发展。

坚持安全可控,微众银行提供隐私计算技术支持

作为国内首家数字银行,微众银行自成立以来,一直以科技为核心驱动力,在区块链、安全多方计算等方面积极开展研究和应用,融合构建隐私计算核心能力。

此次科创平台引入微众银行WeDPR的隐私计算技术,是微众银行应用国产安全可控的数字技术,助力构建国家级健康医疗基础设施、践行ESG服务社会民生的重要实践。

图 WeDPR隐私计算解决方案框架

作为场景式隐私保护解决方案,WeDPR融合了区块链与安全多方计算技术,基于国产开源区块链底层平台FISCO BCOS构建可信协作网络,引入多种安全多方计算协议解决数据协作中的隐私保护问题,实现多方数据的安全可信协作,释放数据生产力。

WeDPR包含了联合报表、联合计算、隐私求交、隐私查询、联合建模和预测等功能需求,支持多方平等、安全地参与隐私数据协作,能够支撑各类商业应用场景灵活拓展,可广泛应用于金融、政务、公共健康、数字权益等领域,有效促进隐私数据有序流通,实现跨域价值融合创新。

凭借领先的技术优势,微众银行在隐私保护领域的攻关成果广泛获得权威机构认可:首批通过中国信息通信研究院“区块链辅助的隐私计算产品”权威评测,安全性、功能、性能全面符合国家权威测评标准;入选中国信息通信研究院可信区块链2021年度高价值案例;入选“全球隐私计算技术发明专利排行榜(TOP100),在所有入选榜单的银行当中名列全球第一。

来源:业界供稿

好文章,需要你的鼓励

世界模拟新引擎:阿里巴巴达摩院发布Inferix,让AI像导演一样制作超长视频

阿里巴巴达摩院联合浙江大学、香港科技大学发布Inferix,这是专为世界模拟打造的下一代推理引擎。它采用块扩散技术,像搭积木般分段生成视频,既保证高质量又支持任意长度,克服了传统方法的局限。配套LV-Bench评测基准包含1000个长视频样本,建立了分钟级视频生成的评估标准,为游戏、教育、娱乐等领域的内容创作带来革命性突破。

Luma AI推出终端速度匹配:一步生成高质量图像的革命性突破

Luma AI推出的终端速度匹配(TVM)是一种革命性的图像生成技术,能够在单次计算中生成高质量图像,突破了传统方法需要数十步采样的限制。该技术通过关注生成路径的"终点"而非"起点",实现了从噪声到图像的直接跳跃,在保证数学理论基础的同时大幅提升了生成效率,为实时AI应用开辟了新路径。

五位自动驾驶产业链大咖畅谈:未来运输的模式、通路与破壁

智能数据将开启AI赋能设计的新纪元

OpenAI 科学家:为什么大语言模型会产生幻觉?

从太空到地面:Qorvo波束成形芯片助力卫星通信发展

豆包语音对话功能更新,能讲4种地道方言,具备思考能力

联想刘军获评“年度科技领军人物” 前瞻布局和实践打造AI落地范本

贝索斯"普罗米修斯项目"收购AI智能体初创公司

全新Mac浏览器Orion发布:主打速度与隐私保护

Opera AI浏览器推出1分钟深度研究模式和Gemini 3 Pro集成

马斯克xAI计划在Colossus数据中心旁建设小型太阳能发电场

微软联手思科那发布零信任光网络架构框架

国内唯一,阿里千问斩获NeurIPS 2025最佳论文奖