赋能全球汽车智能化再加速,亿咖通科技生态日即将开幕

汽车产业正在面临关键的效率竞争,智能化作为全新的价值点,已然成为新阶段角逐的核心。各家车企和一级供应商都在投入大量资源,但无论是技术本身的整合创新,还是面向用户的体验探索,或是构建品牌差异化体验,都成为发展中的系统性难题。想在效率竞争中获得优势,汽车品牌不止需要车规级芯片和软件,更需要完整的解决方案。

作为首家登陆美股的中国汽车智能化初创企业,亿咖通科技即将在3月24日,在武汉体育中心举行首届科技生态日,与行业携手,共同推动全球汽车智能化发展再向前。

全球汽车智能化的底座和枢纽

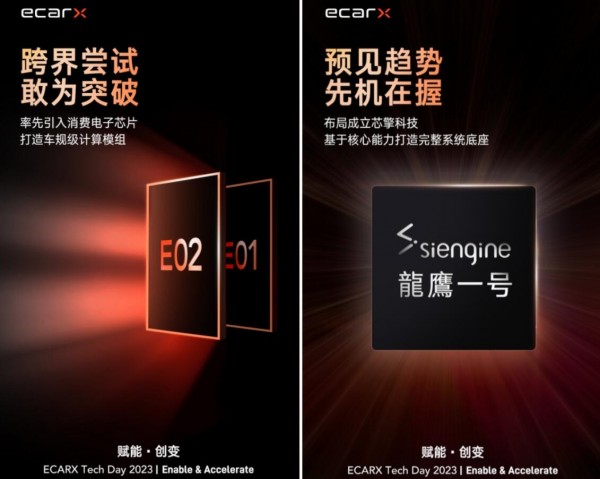

作为一家聚焦B2B模式,专注研发并提供全栈汽车计算平台的公司,亿咖通科技过去被广为人知,更多的是其从2017年创立之始,就在不断大胆创新,包括率先将高性能消费电子芯片整合为车规级计算模组;率先布局芯擎科技,并成功流片全球领先的7nm车规级处理器“龍鷹一号”……多次引领行业技术范式,起到了推动行业发展的关键作用。

与此同时,亿咖通科技的先进技术也在助力其在全球实现快速发展。数据显示,亿咖通科技的技术已被成功应用于全球超 370 万辆汽车,覆盖了包括梅赛德斯奔驰、宝腾、路特斯、smart和吉利汽车在内的12个OEM品牌,还率先与沃尔沃成立了Haleytek,与Luminar、AMD等全球品牌形成深度合作,构建了全球汽车智能化技术生态,成为了中国汽车智能化出海的先锋。

2022年12月21日,亿咖通科技率先通过SPAC方式登陆美股纳斯达克,一举踏入更为广阔的全球市场。

如今,亿咖通科技的技术布局和生态,以及先进的创新战略和产品,将为企业带来完整高效的智能化解决方案。

赋能·创变

首届亿咖通科技生态日将主题定为“Enable & Accelerate 赋能·创变”,表达了其广泛赋能行业,通过深度创新加速行业发展的愿景。

可以期待的是,亿咖通科技将基于已发布的“龍鷹一号”SoC,构建完善的计算平台,为车企提供全新的高性能、车规级、具备差异化的解决方案;同时,亿咖通科技此前在CES 2023中,基于超高性能理念,与AMD携手打造的下一代计算平台也有望同步亮相,展示更多的技术细节;面向域融合及中央计算平台的趋势,亿咖通科技也将交出独特的理解。

此外,备受关注的星纪魅族,也有望在科技生态日期间亮相。

亿咖通科技即将为全球汽车行业带来真正突破、创新、可靠的解决方案,做好底座和枢纽,赋能全球车企和一级供应商,供汽车品牌聚焦资源,构建独特体验以持续领先。

3月24日,相约武汉体育中心,共同加速全球汽车智能化向上开启新征程!

关于亿咖通科技

亿咖通科技,作为纳斯达克上市公司(股份代号ECX),是一家与整车制造商开展合作的全球出行科技企业,旨在汽车行业向全电动的未来转型之际,全力推进重塑行业格局。随着整车制造商从零开发全新的汽车平台,亿咖通科技正在研发一套包括中央计算平台、SoC和软件的全栈式解决方案,助力客户不断提升车内用户体验。亿咖通科技的技术与服务已被应用于超过全球370万辆汽车,并通过持续快速推进智能移动核心技术来塑造人与汽车之间的全新互动关系。

亿咖通科技于2017年成立,团队发展至今已有近2000名员工。公司由两位汽车企业家联合创立。创始人之一的沈子瑜先生担任董事长兼首席执行官,另一位创始人李书福( Eric Li )先生则是世界上最大的汽车集团之一浙江吉利控股集团(“吉利”)的创始人和董事长,该集团持有股份及投资的国际品牌包括路特斯科技(Lotus Technology)、领克(Lynk & Co)、极星(Polestar)、智马达(smart)和沃尔沃汽车(Volvo Cars)等。

来源:业界供稿

好文章,需要你的鼓励

AI商务初创公司Onton获得750万美元融资,挑战零售巨头

随着沃尔玛电商部门年化GMV突破1000亿美元,AI驱动的商务正在加速发展。Onton获得由Footwork领投的种子轮融资,定位为电商决策的起点。该平台通过神经符号引擎解决传统电商搜索痛点,在家居装饰领域快速扩张,月活用户从5万增长至100万。沃尔玛和好市多等零售巨头已在运用AI重塑购物体验,消费者期望正在发生根本性转变。

中科大联手快手:AI视频评判员学会了“边看边想“,彻底解决视频生成质量难题

中科大联合快手等机构推出VR-Thinker技术,首次实现AI视频评判员的"边看边想"能力。该系统通过主动选择关键画面、智能记忆管理和三阶段训练,在视频质量评估准确率上达到75%-82%,特别擅长处理长视频场景,为AI视频生成的质量控制提供了突破性解决方案。

Proximus Global与Starlink扩大欧洲直接到手机卫星连接服务

卫星连接领域领军企业星链与BICS达成战略合作,指定Proximus Global为其在欧洲直连手机卫星服务的首选IPX提供商。该合作将使星链利用现有IPX网络连接移动运营商,并为能够向智能手机提供宽带服务的下一代网络铺平道路。星链直连手机服务拥有超过650颗低轨卫星,可在移动信号盲区提供数据、语音、视频和消息服务,连接五大洲超800万用户。

微软研究院发布BitDistill:让大型语言模型轻松瘦身却不丢性能的魔法

微软研究院发布BitDistill技术,通过三阶段优化将大型语言模型压缩至1.58位精度,在保持性能的同时实现10倍内存节省和2.65倍速度提升。该技术包括模型结构稳定化、持续预训练适应和知识蒸馏传承三个关键步骤,解决了模型量化中的性能衰减和规模化问题,为AI模型在资源受限设备上的高效部署提供了新方案。

Proximus Global与Starlink扩大欧洲直接到手机卫星连接服务

AI基础设施超前建设引发泡沫担忧,CIO如何应对

Vision Pro M5深度评测:苹果需要做出关键抉择

Kovant获得150万美元融资,力图成为企业智能体AI运营中枢

为什么有人担心人类可能会奴役通用人工智能

AMD推动开放生态系统挑战Cuda主导地位

Gemini的AI图像检测工具仅触及表面,这还远远不够

芯片制造商警告DRAM和SSD即将出现短缺

Tuxedo推迟Arm Linux笔记本项目:18个月困难重重宣告放弃

并行文件系统详解:元数据、条带化和吞吐量

亚马逊CTO Werner Vogels预测2026年及未来的五大科技趋势

AI新加坡联手阿里云推出东南亚大语言模型Sea-Lion v4